实验项目三:java api访问hdfs

实验内容与步骤

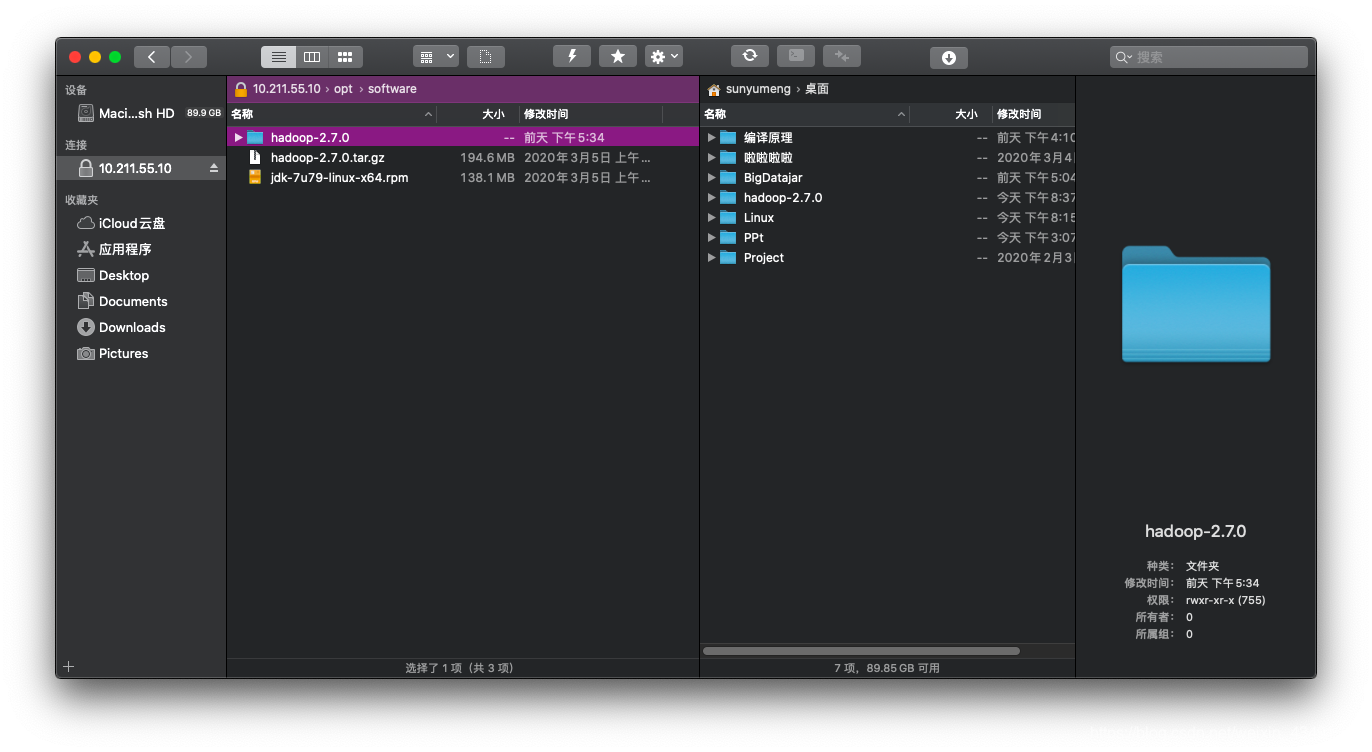

1. 从linux拷贝整个hadoop压缩jar包

使用ForkLift将hadoop文件全部拷出来。

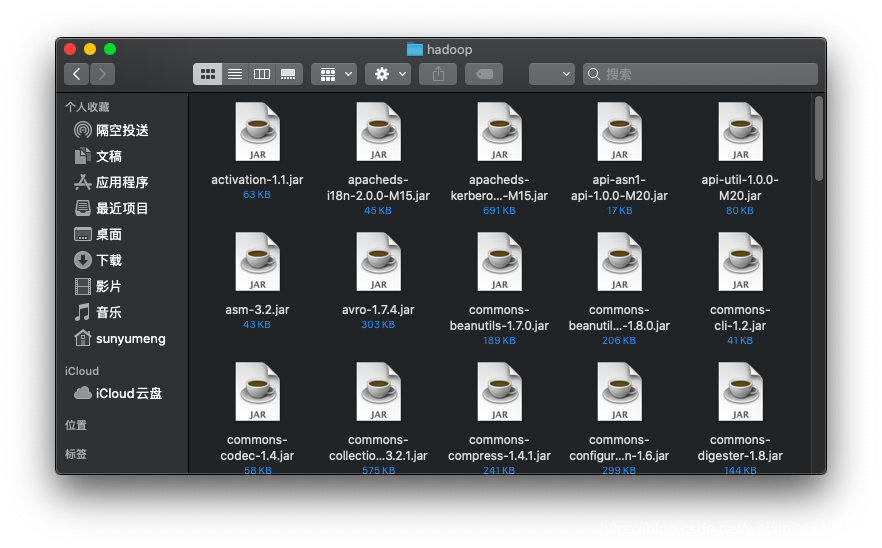

将需要用到的jar包放在一起。(需要的是share/hadoop/common下的三个包,share/hadoop/common/lib文件下全部的包,以及share/hadoop/hdfs下的三个包,以及share/hadoop/hdfs/lib中的包)

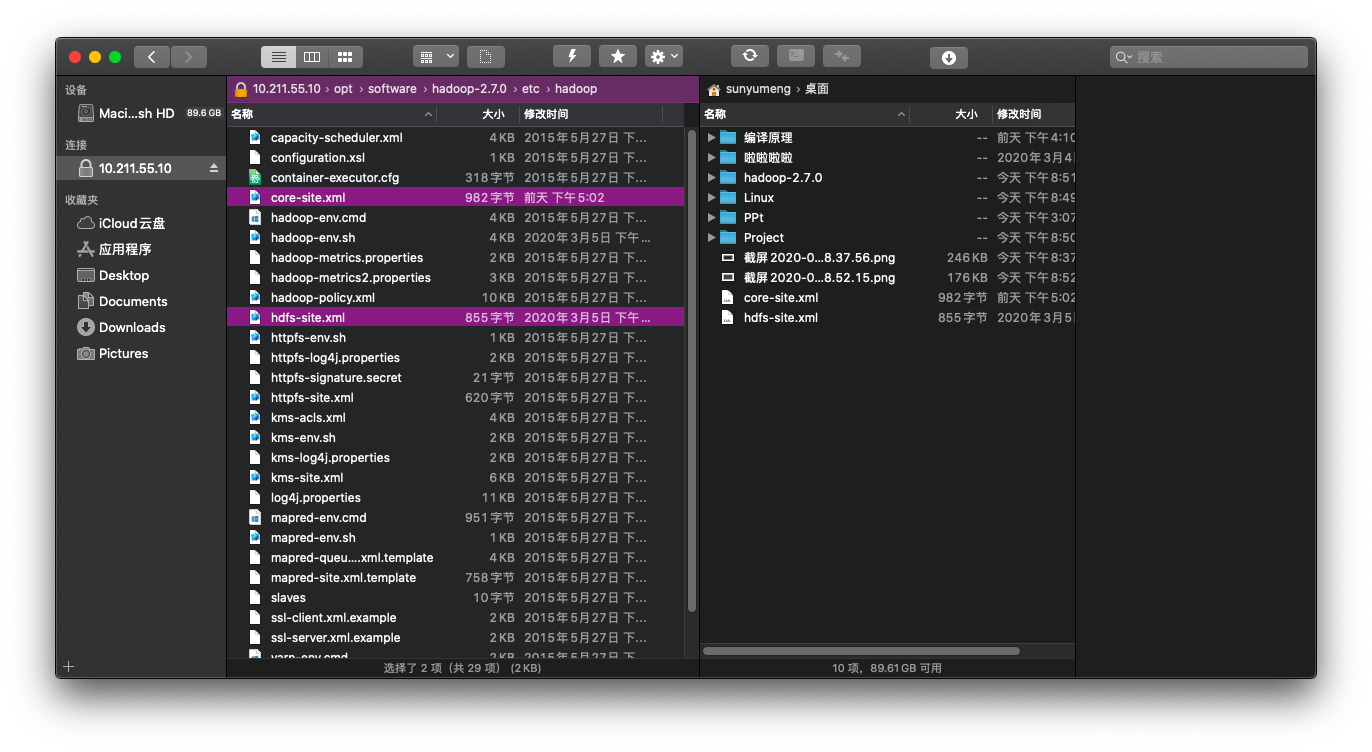

2. 从linux拷出配置文件可以访问hdfs

将core-site.xml和hdfs-site.xml``log4j.properties文件拷出来:

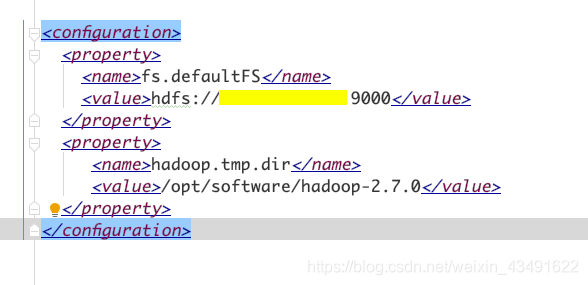

core-site.xml文件需要更改一下:

将黄线的部分改成自己的IP,然后再加上后面的配置就可以。

3. 使用java开发工具编写java代码

简单的配置idea:

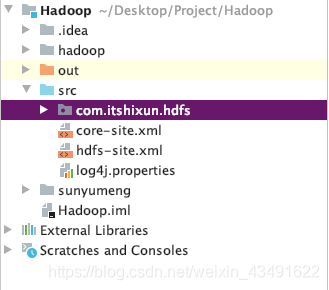

将第二步导出的文件放到src内,第一步导出的hadoop文件夹直接add as library

简单测试一下:

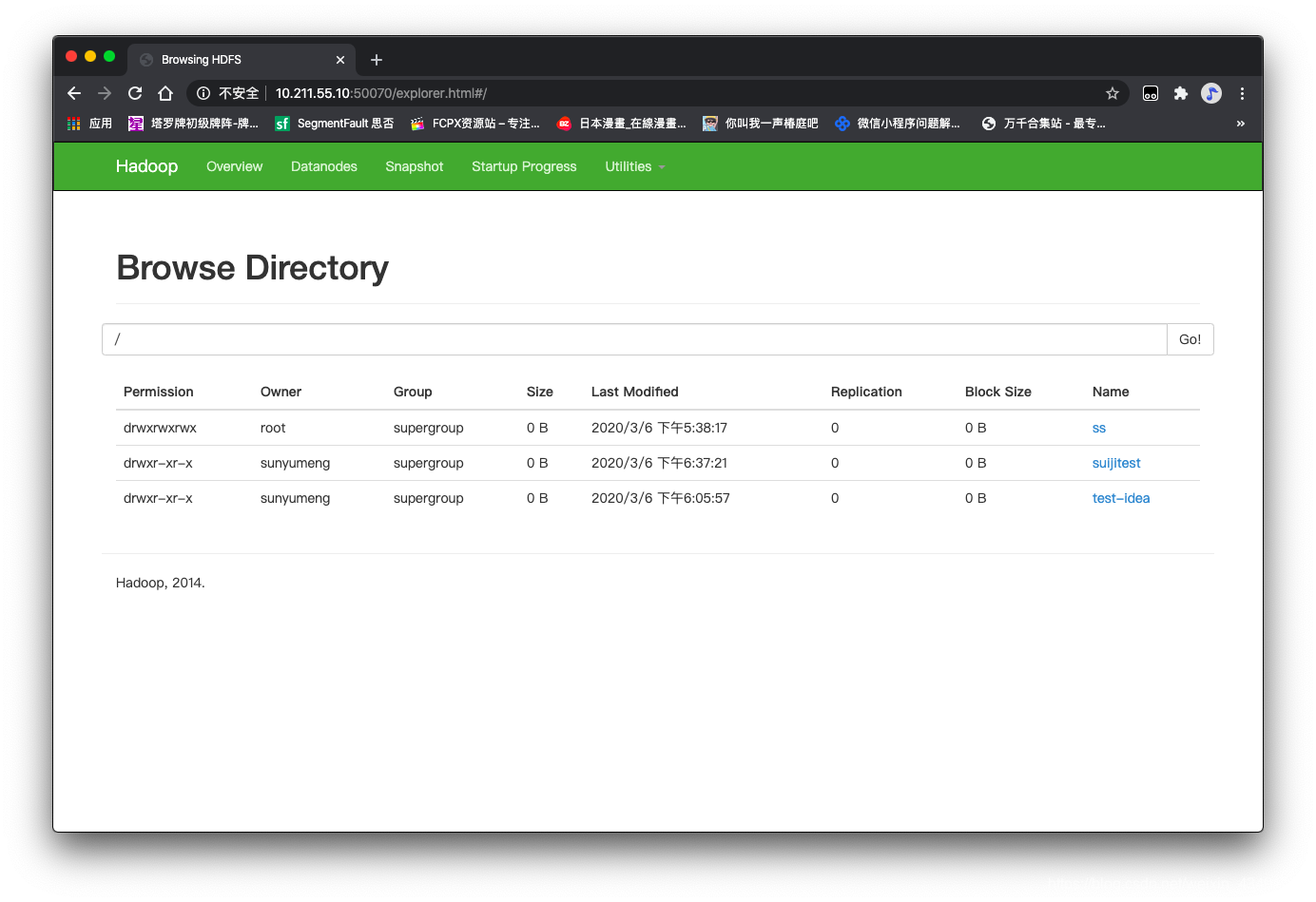

可以看到,在hadoop上成功创建了文件夹。

4. 使用Configuration 类,Path,FileSystem对象完成上传代码

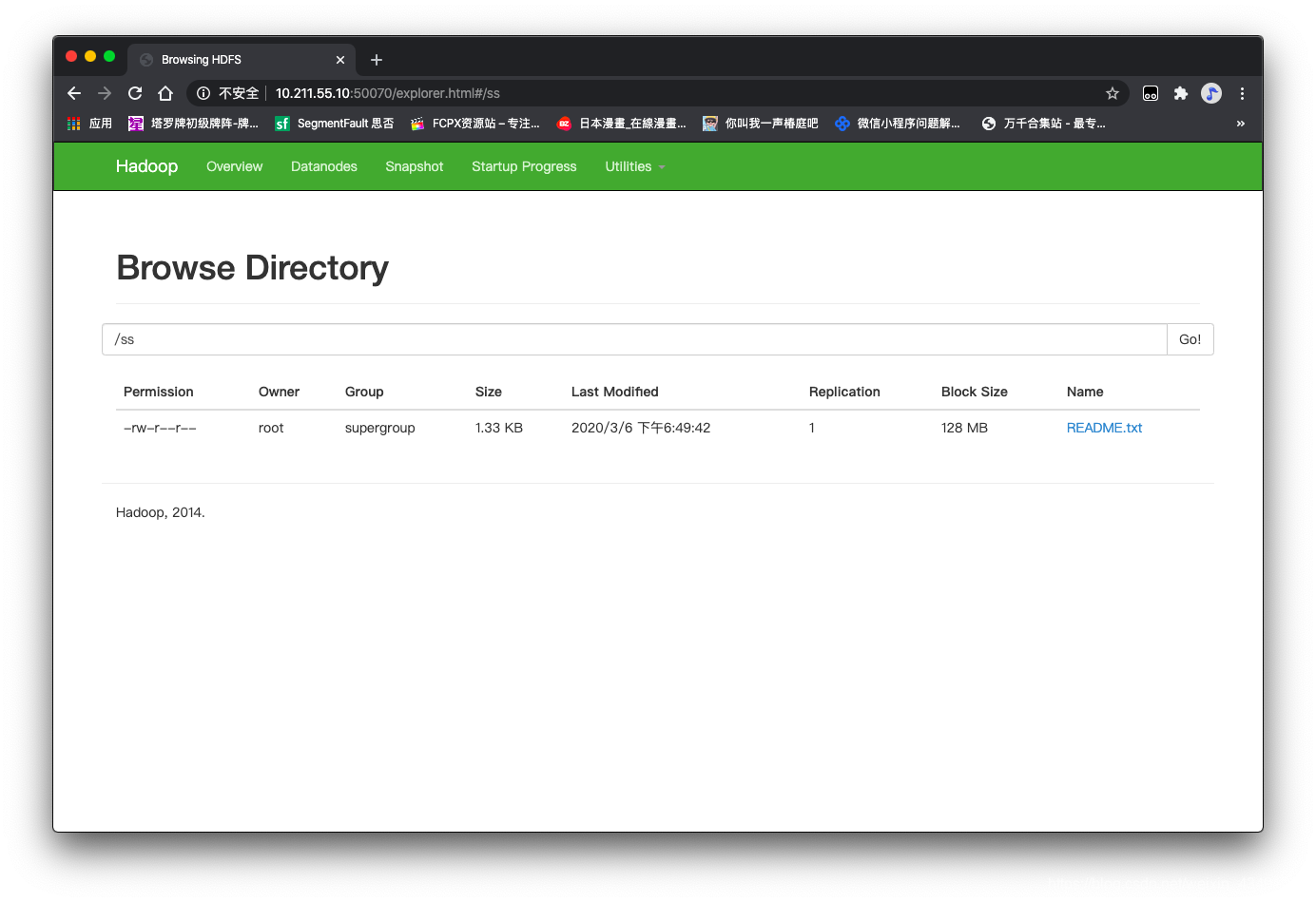

5. 上传文件测试50070测试

成功上传文件。

6. 使用Configuration 类,Path,FileSystem对象完成下载代码

7. 查看下载文件是否存在

可以看到文件也成功下载了。

以下为本次的实验代码:

1 | package com.itshixun.hdfs; |